SLAM: Roboter-Navigation in unbekanntem Terrain

Stellen Sie sich vor, Sie sind in einer unbekannten Wüste gestrandet und stehen vor der beängstigenden Aufgabe, Ihren Weg in sicheres Gebiet zu finden. Die Navigation in unbekanntem Terrain ist seit langem eine Herausforderung für Menschen und Roboter gleichermaßen. Herkömmliche Navigationsmethoden für einen Roboter oder ein autonomes Fahrzeug erfordern eine bereits existierende Karte, aber in unbekannten Gebieten ist es unmöglich, eine solche Karte zu erhalten, ohne das Gebiet zu durchqueren. Dies stellt ein klassisches Dilemma in der Robotik dar, das oft als „Henne-Ei-Problem“ bezeichnet wird. Wie kann ein Roboter in einer unbekannten Umgebung ohne Karte navigieren, und wie kann er eine Karte erstellen, ohne zuvor die Umgebung zu erkunden?

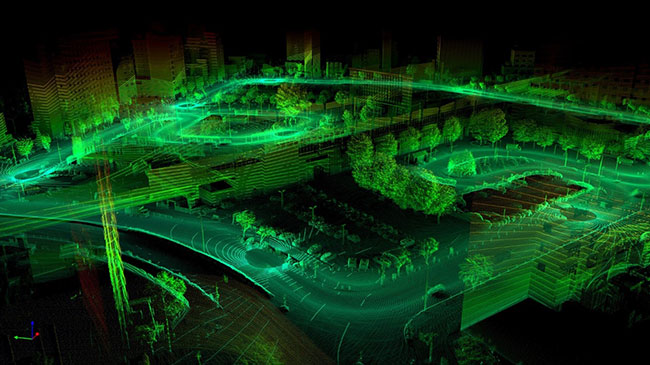

„Visuelle 3D-SLAM-Karte“ oder „SLAM-Karte, die mit visuellem SLAM erstellt wurde“. (Abbildung reproduziert von www.flyability.com - Bildquelle: Sigmoidal.ai)

„Visuelle 3D-SLAM-Karte“ oder „SLAM-Karte, die mit visuellem SLAM erstellt wurde“. (Abbildung reproduziert von www.flyability.com - Bildquelle: Sigmoidal.ai)

Hier kommt das Konzept der Simultanen Lokalisierung und Kartierung (SLAM) ins Spiel. SLAM wurde von Forschern wie Hugh Durrant-Whyte und John J. Leonard entwickelt und ist eine Technik, die es Robotern ermöglicht, unbekannte Umgebungen in Echtzeit autonom zu navigieren und zu kartieren. Anstatt sich auf bereits vorhandene Karten zu verlassen, ermöglicht SLAM den Robotern, Karten ihrer Umgebung zu erstellen und gleichzeitig ihre eigene Position innerhalb dieser Karten zu bestimmen. Im Kern umfasst SLAM zwei Hauptprozesse: Kartierung und Positionsbestimmung. Die Kartierung bezieht sich auf die Erstellung einer räumlichen Darstellung der Umgebung, während die Positionsbestimmung die Bestimmung der Position des Roboters innerhalb dieser Karte beinhaltet. Diese Prozesse sind miteinander verwoben, wobei der Roboter seine Karte auf der Grundlage von Sensordaten ständig aktualisiert und seine Positionsschätzung entsprechend anpasst.

Die Implementierung von SLAM umfasst mehrere Schritte, von denen jeder eine wichtige Rolle im Gesamtprozess spielt. Diese Schritte umfassen die Extraktion von Landmarken, die Zuordnung von Daten, die Schätzung des Zustands und die Aktualisierung. Bei der Landmarkenextraktion geht es darum, bestimmte Merkmale in der Umgebung zu identifizieren, die als Referenzpunkte für die Kartierung und Positionsbestimmung verwendet werden können. Bei der Datenzuordnung geht es um den Abgleich von Sensormessungen mit Merkmalen in der Karte, während bei der Zustandsschätzung die Position und Ausrichtung des Roboters anhand der Sensordaten geschätzt wird. Bei der Aktualisierung werden die Karte und die Positionsschätzungen auf der Grundlage neuer Sensormessungen verfeinert.

Einer der Schlüsselfaktoren, die die Effektivität von SLAM bestimmen, ist die Art der verwendeten Sensoren. Verschiedene Sensoren bieten unterschiedliche Genauigkeits- und Informationsniveaus, was sich auf die Qualität der resultierenden Karten und Positionsschätzungen auswirken kann. Beim visuellen SLAM (vSLAM) beispielsweise werden Kameras als primäre Sensoren eingesetzt, so dass der Roboter visuelle Informationen aus seiner Umgebung extrahieren kann. Diese visuellen Informationen können Merkmale wie Kanten, Ecken und Texturen enthalten, die als Orientierungspunkte für die Kartierung und Positionsbestimmung verwendet werden können. Darüber hinaus liefern Kameras umfangreiche semantische Informationen, die bei Aufgaben wie der Objekterfassung und -erkennung hilfreich sein können. Das LiDAR-basierte SLAM hingegen nutzt LiDAR-Sensoren (wie den SLAMTEC SEN-15870 von SparkFun), die Laserstrahlen aussenden, um die Entfernung zu Objekten in der Umgebung zu messen. LiDAR-Sensoren bieten eine hohe Genauigkeit und Präzision und eignen sich daher gut für die Kartierung von Umgebungen mit komplexer Geometrie. LiDAR-Sensoren können jedoch teuer und rechenintensiv sein, was ihre Anwendbarkeit in bestimmten Szenarien einschränken kann.

Es gibt mehrere Unterkategorien für vSLAM, die sich nach der Art der verwendeten Kamera richten. Dazu gehören monokulares SLAM, Stereo-SLAM und RGB-D-SLAM. Monokulares SLAM verwendet eine einzige Kamera, um die Bewegung des Roboters und die Struktur der Umgebung abzuschätzen. Bei Stereo-SLAM wird eine Stereokamera verwendet, die aus zwei Kameras besteht, die in einem bekannten Basislinienabstand zueinander angeordnet sind. Dieser Aufbau ermöglicht die Triangulation von visuellen Merkmalen, was zu einer verbesserten Tiefenschätzung und Kartierungsgenauigkeit führt. Bei RGB-D-SLAM schließlich wird eine herkömmliche RGB-Kamera mit einem Tiefensensor kombiniert, z. B. einer Microsoft-Kinect- oder Intel-RealSense-Kamera. Diese zusätzlichen Tiefeninformationen ermöglichen eine genauere 3D-Kartierung und Positionsbestimmung.

Jede Unterkategorie von vSLAM hat ihre eigenen Vorteile und Einschränkungen, die von Faktoren wie Kosten, Rechenaufwand und Umweltbedingungen abhängen. Monokulares SLAM zum Beispiel ist aufgrund seiner Einfachheit und geringen Kosten weit verbreitet. Es leidet jedoch unter der Mehrdeutigkeit des Maßstabs, da es den Maßstab der Umgebung nicht direkt abschätzen kann. Stereo-SLAM löst dieses Problem, indem es die Triangulation von visuellen Merkmalen nutzt, um Tiefe und Maßstab zu schätzen. RGB-D-SLAM hingegen bietet dank der Kombination von RGB-Bildern und Tiefeninformationen das höchste Maß an Genauigkeit und Detailgenauigkeit.

Neben seinen Anwendungen in der Robotik hat SLAM auch zahlreiche reale Anwendungen in verschiedenen Branchen. In der Robotik ermöglicht SLAM Robotern die autonome Navigation und Erkundung dynamischer Umgebungen, wie z. B. Lagerhäuser, Fabriken und Katastrophengebiete. In autonomen Fahrzeugen wird SLAM eingesetzt, um hochauflösende Karten von Fahrbahnen zu erstellen und das Fahrzeug innerhalb dieser Karten zu lokalisieren. SLAM wird auch in den Bereichen Augmented Reality (AR) und Virtual Reality (VR) eingesetzt, um durch die Überlagerung von virtuellen Objekten mit realen Umgebungen immersive Erfahrungen zu schaffen.

Trotz seiner vielen Vorteile ist SLAM nicht ohne Nachteile. Eine der größten Herausforderungen bei SLAM ist die Komplexität der Verarbeitung von Sensordaten und die Aktualisierung der Karte in Echtzeit. Dies kann in Umgebungen mit großen Datenmengen oder begrenzten Rechenressourcen eine besondere Herausforderung darstellen. Außerdem ist SLAM in hohem Maße von der Verfügbarkeit eindeutiger Merkmale und Orientierungspunkte in der Umgebung abhängig. In Umgebungen mit gleichförmigem oder unstrukturiertem Gelände kann SLAM Schwierigkeiten haben, genaue Karten zu erstellen oder die Position des Roboters effektiv zu bestimmen.

Zusammenfassend lässt sich sagen, dass die simultane Positionsbestimmung und Kartierung (SLAM) eine leistungsstarke Technik ist, die es Robotern ermöglicht, unbekannte Umgebungen in Echtzeit autonom zu navigieren und zu kartieren. Durch die Kombination von Kartierung und Positionsbestimmung in einem einzigen Prozess ermöglicht SLAM den Robotern, ihre Umgebung ohne Vorkenntnisse oder bereits vorhandene Karten zu erkunden und zu verstehen. SLAM bringt zwar eine Reihe von Herausforderungen und Einschränkungen mit sich, doch seine Anwendungen sind umfangreich und vielfältig und erstrecken sich über Branchen wie Robotik, autonome Fahrzeuge, AR und VR. Im Zuge des technologischen Fortschritts spielt SLAM eine immer wichtigere Rolle bei der Gestaltung der Zukunft der Robotik und Automatisierung.

Referenzen:

- Was ist SLAM? (Simultane Positionsbestimmung und Kartierung) (vercator.com)

- Einführung in SLAM (Simultane Positionsbestimmung und Kartierung) | Ouster

- Von Null auf SLAM in 30 Minuten: ein interaktiver Workshop | Ouster

- Was ist SLAM (Simultane Positionsbestimmung und Kartierung) - MATLAB & Simulink (mathworks.com)

- SLAM; Definition und Entwicklung - ScienceDirect

- Eine Einführung in die wichtigsten Algorithmen für SLAM - Technische Artikel (control.com)

- Positionsbestimmung - Einführung in die Robotik und Wahrnehmung (roboticsbook.org)

Have questions or comments? Continue the conversation on TechForum, Digi-Key's online community and technical resource.

Visit TechForum